概览

1.将hadoop的hdfs-site.xml和core-site.xml 放到flume/conf下

2.将hadoop的jar包拷贝到flume的lib目录下

3.配置flume2.conf

4.启动flume(保证首先启动hdfs)

5.测试

6.注意

准备

首先将flume配置完毕,参考flume的单机版配置及测试

hadoop集群搭建完毕,参考hadoop单机版搭建,hadoop集群搭建

工具:Xshell 5,Xftp 5

1.将hadoop的hdfs-site.xml和core-site.xml 放到flume/conf下

1 | [root@localhost ~]# cp /usr/hadoop/hadoop-2.7.3/etc/hadoop/core-site.xml /usr/flume/apache-flume-1.8.0-bin/conf/ |

2.将hadoop的jar包拷贝到flume的lib目录下

1 | [root@localhost ~]# cp $HADOOP_HOME/share/hadoop/common/hadoop-common-2.7.3.jar /usr/flume/apache-flume-1.8.0-bin/lib/ |

3.配置flume2.conf

在flume安装目录下的conf下创建一个flume2.conf文件,并写入配置

1 | #定义agent名, source、channel、sink的名称 |

4.启动flume(保证首先启动hdfs)

启动hdfs参考hadoop单机版搭建,hadoop集群搭建中的hadoop启动

1 | [root@localhost apache-flume-1.8.0-bin]# flume-ng agent -n a4 -c conf -f conf/flume2.conf -Dflume.root.logger=INFO,console |

5.测试

重新打开一个窗口

在/usr/tmp下创建一个a文件

1 | [root@localhost ~]# cd /usr/tmp/ |

随便输入一些内容

1 | dada |

保存退出,将其copy到logs文件夹下

1 | [root@localhost tmp]# cp a /logs/ |

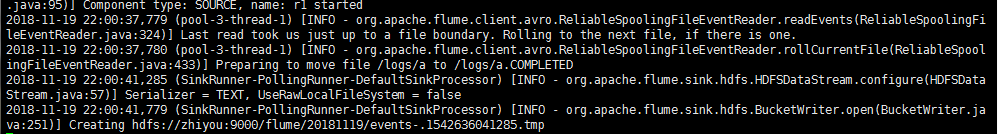

查看原来的窗口

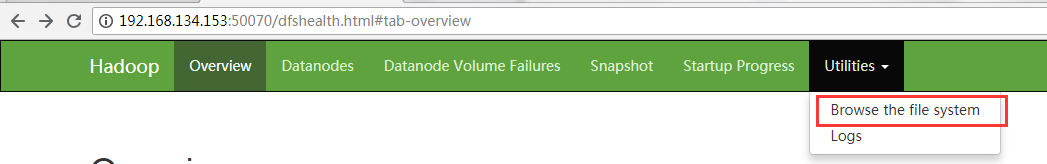

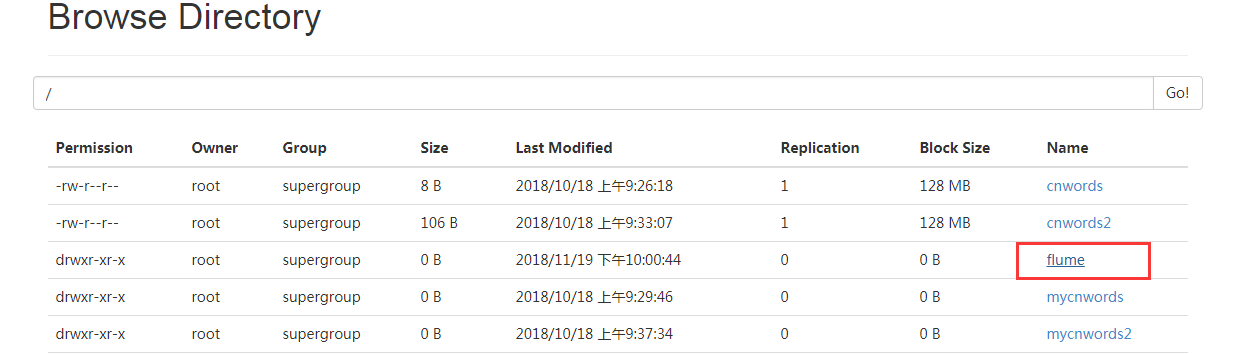

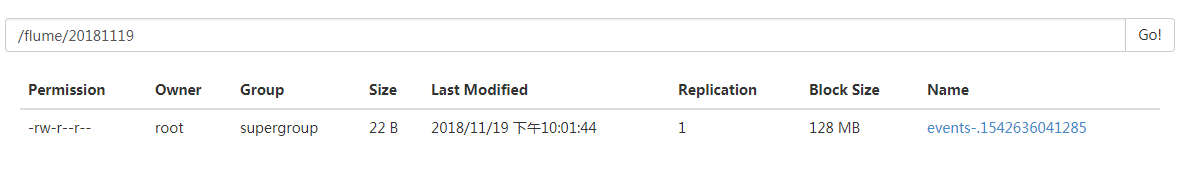

然后登录http://你的主机ip:50070查看

如此便是采集日志到hadoop成功了

6.注意

注意在测试的时候不能同时开启两个监控目录的flume,不然会出异常