概览

1.Linux上进行上传下载查询操作

2.Java代码实现上传下载查询操作

上次将Hadoop集群版搭建完成了,那么怎么上传下载文件呢?

1.Linux上进行上传下载查询操作

首先将Hadoop服务启动

将master,slave1,slave2三台虚拟机启动

在master上启动Hadoop服务

1 | start-all.sh |

然后jps查看命令是否启动成功,和Hadoop集群搭建中验证方法一致

确认启动成功后,使用Xshell分别连接虚拟机

这时候需要你先将需要操作的文件传输到虚拟机中或者在虚拟机中创建文件

使用Xftp将文件上传到虚拟机中或者自己创建文件,我们就将文件放置在/usr/tmp中

1 | cd /usr/tmp |

然后我们创建一个文本文件

1 | #touch 创建文件 mkdir 创建文件夹 |

可以随便输入一些内容

1 | hello world |

保存退出

然后将文件上传到hdfs根目录中

1 | #将文件上传到Hadoop根目录中 |

文件上传成功了,那么接下来试一试文件夹

1 | #创建文件夹 |

删除文件/文件夹

1 | #删除文件 |

将hdfs上的文件下载到本地

1 | #将文件上传上去 |

这就是几种基本的Linux上进行上传下载查询操作

2.Java代码实现上传下载查询操作

启动eclipse或者其他工具

新建个Java项目,test包,TestHadoop类

然后在项目下创建个lib文件夹存放jar包

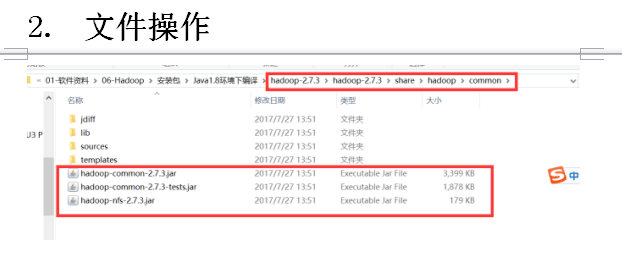

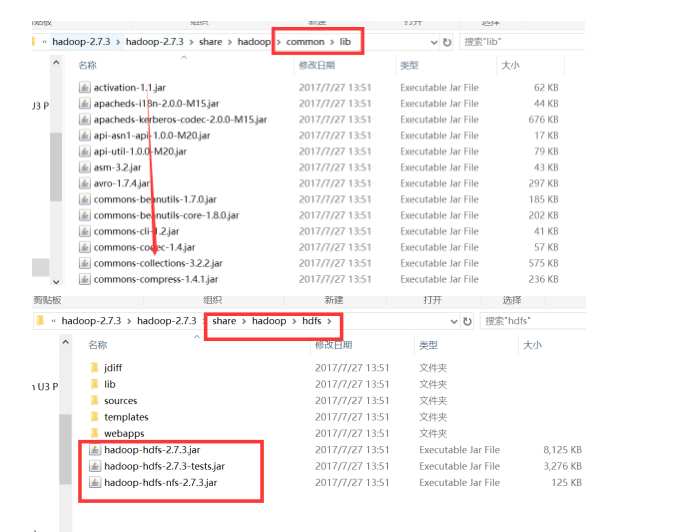

将hadoop解压文件夹中的jar复制到lib内

如图,大概共有69个jar包

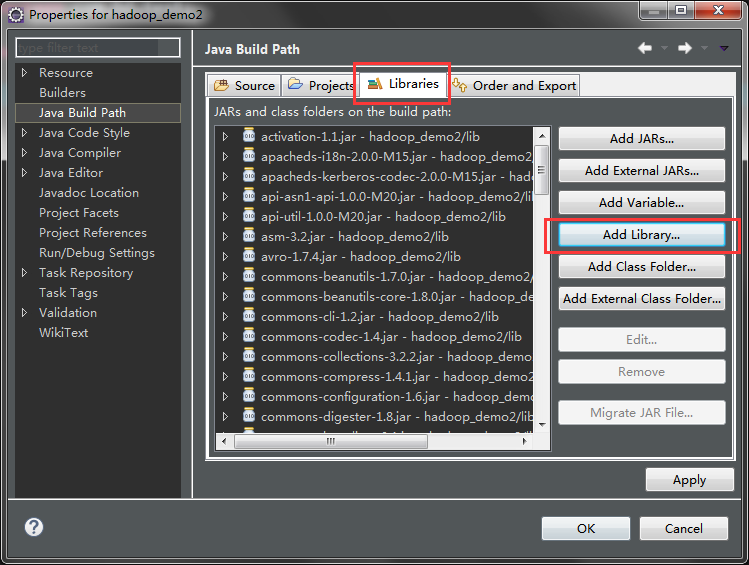

然后在eclipse中选择lib文件夹下所有jar包–>右键Build Path–>add to Build Path

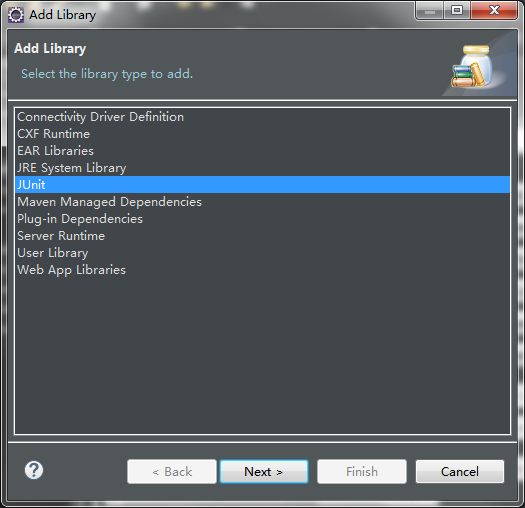

因为是测试类,所以我们将JUnit4导入到Path中

在项目上右键–>Build Path–>Confirgure Build Path

然后,这是TestHadoop的内容

1 | package com.hd.test; |

每次运行只要双击方法名然后右键Run –>JUnit Test就能测试运行

然后分别在hdfs上 , 本地E盘 和 eclipse控制台 查看是否运行成功

以后会接着介绍更多的关于hadoop的操作